摘要:网站长时间不收录怎么办?针对页面不收录有什么解决办法吗?不少SEO从业者都遇到过类似问题,今天给大家讨论一下页面不收录的原因和解决方案。今天一位SEO朋友来问...

网站长时间不收录怎么办?针对页面不收录有什么解决办法吗?

不少SEO从业者都遇到过类似问题,今天给大家讨论一下页面不收录的原因和解决方案。

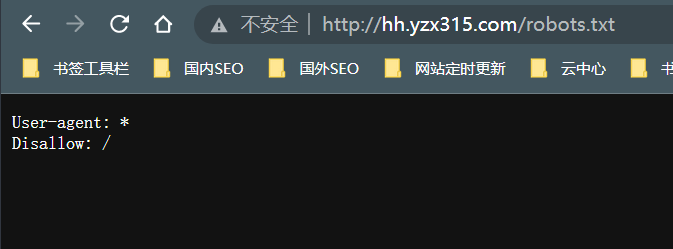

今天一位SEO朋友来问客户的网站收录的问题,经分析才发现苦苦优化经了一个月的网站竟然是“屏蔽状态”的,罪魁祸首就是网站添加了错误的robots协议规则“Disallow: /”

懂SEO的人都知道robots是蜘蛛程序来抓取网站首先要访问的一个协议文件,Disallow不允许限止的意思; “/”的意思就是限止抓取网站所有页面目录。当网站搭建完成上线时就一定要检查robots.txt里面是否删除了限止抓取规则。

合理的使用robots规则

每个网站都需要制定适合网站本身的robots规则,正确的robots规则可以提升spider抓取的效率,告诉spider蜘蛛程序哪些页面路径允许抓取那些页面不允许抓取,对于搜索引擎来说是有利的。

这是robots文件的具体用法,可参见:https://ziyuan.baidu.com/college/courseinfo?id=267&page=13#h2_article_title30

网站不收录怎么解决?

第一时间删除robots里面的Disallow: / 根据网站程序结构撰写适合的robots,比如屏蔽抓取404错误页面,后台登录页面和涉及到用户安全数据隐私等信息,都可以采用规则来屏蔽spider的抓取。

其次,为网站合成全站sitemap地图,比如sitemap.xml 上传到网站根目录中,添加至网站的robots.txt中,比如

sitemap:https://www.ainiseo.com/sitemap.xml

这样,当spider蜘蛛再次来访问robots时就可以快捷的识别出网站的所有url地址。

最后,在百度站长平台工具中-普通收录-提交sitemap地图

https://ziyuan.baidu.com/linksubmit/index?

以便于百度搜索引擎蜘蛛最快的发现并抓取到地图,从而实现页面的快速收录。

当然,网站不收录的原因也有很多,具体网站具体分析,逐一排查都可以解决。

希望对SEO站长朋友有帮助。